如何认识、理解和用好ChatGPT

对 ChatGPT 的常见误区是什么?

首先,ChatGPT 是 GPT 模型,全称为"Generative Pre-trained Transformer”。目前是 GPT3.5 代。GPT 模型是一种 LLM,本质还是语言模型,而不是不了解 AI 发展的朋友们通常提到 AI 所想到的 AGI。

LLM V.S. AGI 区别是什么

LLM的全称是"Large Language Model",它是指以自然语言为基础,利用深度学习技术构建的大型语言模型。LLM 通过大量的训练数据和算法,可以学习自然语言的规则和特征,从而实现自然语言生成、理解、问答等任务。目前,最著名的 LLM 是 OpenAI 的 GPT系列模型,包括 GPT-3、GPT-2 等。

AGI的全称是"Artificial General Intelligence",它是指一种能够像人类一样执行多种智能任务的人工智能系统。AGI 是指能够像人类一样进行推理、学习、自我修复、自我意识等多种智能行为的智能系统。与 LLM 不同的是,AGI 具有更广泛的应用领域和更强的智能能力。

总的来说,LLM 和 AGI 在技术层面和应用领域上存在着巨大的差异。LLM 侧重于自然语言处理和智能问答等任务,而 AGI 则更为广泛,可以在多个领域进行多种任务的处理和应用。此外,AGI 的研究和实现需要更为复杂和高级的技术和算法支持,与 LLM 相比,还处于更早的研究和发展阶段。

- ChatGPT 是语言模型,不是通用人工智能。

- 不要拿红色蜡笔,想画蓝色海洋。

介于很多朋友阅读速度很快,这里狠狠重复一下……如果只有一个 take away,那就是这两句。

如何理解 ChatGPT

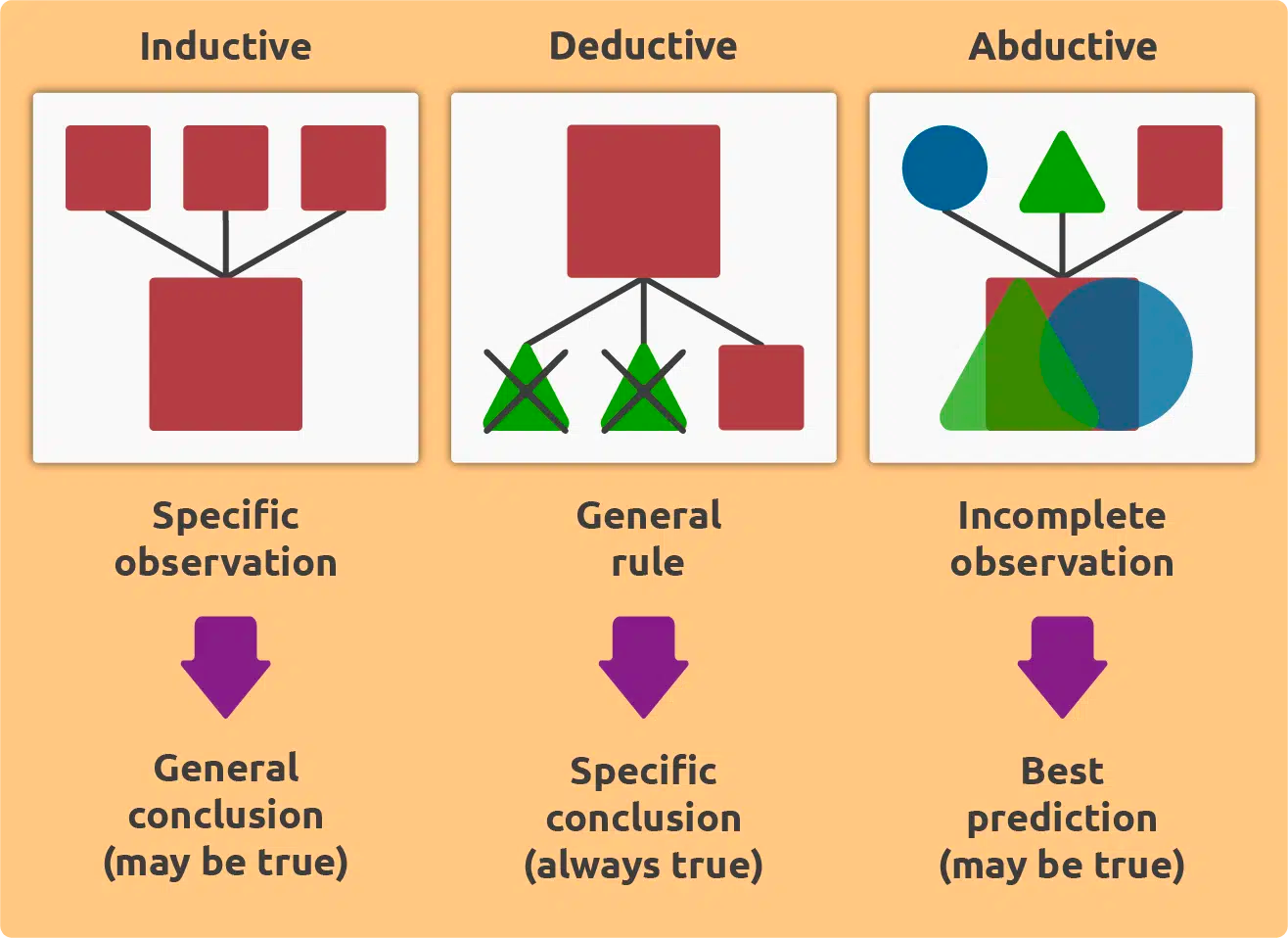

想要理解 ChatGPT,首先要理解这三种逻辑推理方法。

- 归纳逻辑 Inductive Logic(什么是 ChatGPT 能做的)

- 演绎逻辑 Deductive Logic(什么是 ChatGPT 暂时不能做的)

- 溯因逻辑 Abductive Logic(什么是人能做,但 ChatGPT不能的)

假设有一个实验,研究人员对某种新药进行了临床试验,并对试验结果进行了数据分析。现在我们来举例说明这三种逻辑推理方法如何应用于这个实验。

归纳逻辑

- 在归纳逻辑中,我们通常从特定的实例中归纳出一般的规律和定律。在这个例子中,我们可以根据试验的结果,观察这种新药的疗效,然后推断出这种新药在人类中的作用规律。例如,如果试验表明该药物可以有效地治疗某种疾病,那么我们可以推断这种药物对该疾病具有普遍的治疗效果。在这个过程中,我们从特定的实例中归纳出了一般的规律,这是归纳逻辑的一个典型应用。

演绎逻辑

- 在演绎逻辑中,我们通常通过利用已知的普遍规律或定律来推导出特定的结论。在这个例子中,我们可以利用已知的医学原理和已知的药物成分等信息,来推导出该新药物是否具有治疗效果。例如,如果我们已经知道了该药物的成分,以及这些成分对人类身体的作用规律,那么我们就可以通过演绎逻辑的推理方法,推导出该药物对某种疾病是否具有治疗效果。

溯因逻辑

- 在溯因逻辑中,我们通常通过选择一个最有可能的解释来解释已知的事实或现象。在这个例子中,我们可以根据已知的实验结果,以及已知的医学原理和药物成分等信息,选择一个最有可能的解释来解释这些实验结果。例如,如果我们发现这种新药物具有治疗某种疾病的作用,但我们尚不确定该药物的作用机理是什么,那么我们可以通过选择一个最有可能的解释来解释这种药物的作用。这种解释可能是该药物作用于某种特定的细胞或分子,从而产生治疗效果。在这个过程中,我们通过阐述逻辑来解释了已知的实验结果。

归纳逻辑 Inductive Logic

- 什么是 ChatGPT 能做的?

- LLM 的本质是统计学,所以学习了大量语言数据的 ChatGPT 有很强的语言组织能力,并不是因为它精通语义学,而是它知道一个词后面大概率跟什么词,大概率组成什么句子。ChatGPT 行文组织的能力,是基于统计学而不是语义学,更不是专业领域的知识体系。

- 这帮助我们理解 ChatGPT 擅长的任务是什么、该如何和 ChatGPT 沟通、如何高效利用好 ChatGPT。

演绎逻辑 Deductive Logic

- 什么是 ChatGPT 暂时不能做的?

- ChatGPT 之所以写出漂亮的文章或措辞,不是因为它有很强的文学造诣,而是因为人类提供给它足够优秀的训练语料,让它知道在漂亮的文章里,一个词后面大概率跟什么词,大概率组成什么句子。换言之,ChatGPT 不具备任何从专业领域的知识体系中,推理分析内容的能力。即使在任何例子中,它看似完成了这一点,也是因为统计学而不是真正具备这样的能力。因为通常这样的结果是经不起推敲和辩驳的。

- 这帮助我们了解 ChatGPT 的边界是什么。ChatGPT 的输出结果哪些是可信的、哪些是需要质疑的。哪些任务是目前不值得你向 ChatGPT 提出的、ChatGPT 未来努力的方向是什么,KG 研究未来有没有结合的可能性。

溯因逻辑 Abductive Logic

- 什么是人能做,但 ChatGPT 不能的?

- ChatGPT 目前被训练得非常得体,遵守礼仪规矩,说不出错的话。换言之,ChatGPT 不能说“胡话”。(如果是专业知识的胡诌,属于上一种类型)这跟 ChatGPT 是 Inductive Logic 的表达也有关。ChatGPT 无法跳出学习资料以外回答你。也就是说,ChatGPT 还不具备对未知现象提出假设的能力。尽管大多数人未经训练也不具备这个能力。

- 这帮助我们了解 ChatGPT 做不到,但人有可能做到的事情。人在未来的竞争力是什么,而一旦 ChatGPT 展露出具备这种能力时,又意味着什么。

如何用好 ChatGPT

网络上关于 ChatGPT 的 Prompt 一搜一大把,这里简单推荐几个网站。

https://platform.openai.com/examples

https://github.com/f/awesome-chatgpt-prompts

简单说下 ChatGPT 擅长的任务:

一、回答具体的知识问题

不管是 coding、哲学观点研究还是紫微斗数。

ChatGPT 是非常好的老师,它可以条理清晰、有针对性地回答你的问题,而且你可以不断地追问细节。这意味着学习资源空前平等,只要你有心想学。但记住永远保持质疑精神。

通常全网知识越常见的内容,回答越好,反之越差。比如中医药、八卦五行的问答里,就会存在胡说八道的情况。但是偏门知识也有引导的 tricks,比如在新建对话中,先从 ChatGPT 可能更容易聊对的内容/概念聊起,再去问你想知道的问题。这是因为同一会话的历史语料会作为 prompt 影响到 ChatGPT 的下一次输出。越多的 context 给到 ChatGPT,它就能对特定语境下的特殊词汇和问题,有更好的表现。

二、解决语言问题

练习英语表达、给代码 debug 、扩写缩写复述等等,只要是语言。

训练了全网做多语言数据的模型,能力有多强不用我多说。在很多问题上,它甚至比你学校的老师,回答更出色。但仍然也有 ChatGPT 解答不了的语言问题,不妨换个问法试试,或者先做些 context 的输入和引导。记住,我们用 ChatGPT 是为了自己的进步成长,得到自己想要的知识,而不是为了刁难它,说出一句它果然不行。同样的,永远保持质疑精神。

三、高级废话文学

周报、PPT、公文、申请、总结、运营文案、商务交流等等。

没有比看过全网废话文学的 LLM 更能说高级废话了。如果 ChatGPT 写不出来,只能说你 prompt 水平不行。思路还是一样的,只要你知道 ChatGPT 是基于统计学的,把 prompt 往你想要的内容上引就可以了。尽可能在会话中提供更多的细节、要求、上下文,一次问不出来,可以把问题拆成好几个问,循序渐进得到结果。

四、输出机器懂的语言

其他模型的prompt,其他框架/服务的指令、接口等等

尝试把 ChatGPT 想象成机器大脑,正在说 language in the brian。你永远想不到 ChatGPT 可以给你多惊艳的输出。

ChatGPT 有可能会带来哪些影响

首先,我们聊过 ChatGPT 是语言模型。那么我们就要看语言意味着什么?

- 语言是人类的交流工具,最主要的交互形式之一。

- 语言是网络数据最大的载体,哪怕音频、视频都可以转换成文本数据。

- 语言除了 natural language,还有 coding language,和 language in the brain。

- 语言的边界就是思想的边界 。

语言交互,文字或语音

- ChatGPT 已经改变了搜索引擎。可想而知未来会改变更多的交互形式。所有的检索才能得到信息的场景,都可以尝试加上对话入口。也就是说,更多的垂直领域,产品的使用指南、服务支持,都会从原来的文档或笨拙的智能客服,全面转向 GPT 模型 + 弱人工的处理形式。未来将会有很多对话语料设计与分析的场景。

- 所有工具类、效率类、任务导向的 APP/交互/功能都将面临智能化的转型。数字化转型曾经历的事情,都有可能在智能化转型中经历一遍。包括探索的过程和流程化、工程化、自动化。工具和效率类 APP 首当其冲的原因是,LLM 是擅长 coding language 的,自然从 natural language 到 coding language 也不在话下。对应到现在的研究领域就是 NL2SQL,和所有 NL2codes、2function、2commands 的扩展场景,都值得期待。

- 由于信息获取方式的转变,流量的入口也会一部分从瀑布信息流变成会话聚焦型。这种情况下,平台方无法像传统的搜广推 rankings 给到内容创作者推荐和流量。那首先双方的利益关系会被重建,以及如何再达到一种平稳的状态。我们都需要思考新的商业关系、交互呈现形式以及技术手段,如何能满足双方的诉求。

语言的多媒体载体,文本、音频、视频

- 语言模型不仅赋能文本生成,也将极大降低分析和生成和语言息息相关的音频和视频内容。文本的模型处理能力,能将整个互联网信息数据整合起来。再加上多模态模型的发展,图片、声音等都会加入整个语义网络 semantic web。语义网络的未来近在咫尺。

- LLM 不仅会成为 language 任务的 copilot,比如 GitHub 出的 copilot 和 notion 出的 notionAI,还将成为大多数的生产工具的 copilot,而且尽在咫尺,相信在 2023 的下半年,就会爆发普及很多的 x-copilot 的产品、工具和服务。

natural language,coding language 和 language in the brain 让 ChatGPT 成为机器意识

- ChatGPT 在 coding language 上的表现不输 natural language,是因为编程语言是有规则、有序的。ChatGPT 在两种语言上融会贯通的优越表现,已经表明 ChatGPT 具备转译能力,传统学术研究上是 NL2SQL 赛道,但 ChatGPT 能做的已经远远超过 SQL。目前来看,没有比 ChatGPT 更适合成为机器的 language in the brain。

- "Language in the brain" 是意识的一个重要组成部分,因为语言是人类意识的重要载体和表达方式。全局工作空间理论认为,意识是由全局工作空间中的信息所构成的,而全局工作空间是大脑中多个模块之间共享的一个信息处理系统。语言作为一种信息的表达方式,在全局工作空间中扮演了重要的角色。全局工作空间理论(Global Workspace Theory)是由美国心理学家 Bernard Baars 在1988年提出的一种心理学理论,它用于解释人类意识的本质和机制。

- 为什么 ChatGPT 有潜力成为机器意识?

- ChatGPT 已经连接起自然语言和机器语言

- ChatGPT 已经具备交流沟通的能力

- ChatGPT 已经具备理解 context 的能力

- ChatGPT 已经具备推理的能力

- ChatGPT 在 context awareness 问题上表现出来的泛化能力和潜力已经超过绝大多数算法模型

- ChatGPT 目前还没有成为机器意识,但我们可以通过 finetuning 和 prompt engineering 训练它,让它逐步模拟GWT

- 垂类高集成、高自动化、高智能的 AI 指日可待

语言的边界就是思想的边界

- 美国语言学家和哲学家Benjamin Lee Whorf强调了语言和思想之间的互动性,并提出了"语言的边界就是思想的边界"的观点。他认为,不同的语言系统对现实世界的理解和表达方式是不同的,因此人们的思想和理解也会受到语言的限制。

- 维特根斯坦认为,语言的边界塑造思想的边界,这意味着语言和思想之间存在着密切的关系。他认为,语言不仅仅是一种表达思想的工具,更是塑造思想的方式。因为语言决定了我们所能想到的东西,甚至塑造了我们的观念和信仰。

- 过往我们接触知识的来源五花八门,课堂、书籍、演讲、讨论……而现在 ChatGPT 可以给我们不一定是最好的,但一定是最快的知识回答。网上看到一个比喻,说 ChatGPT 是将几十年互联网的文本信息压缩成低清缩略图,使得用户很快可以窥探全貌、看个大概。同时也因为高度压缩,丢掉了很多细节。长此以往,随着 ChatGPT 的能力越来越强, 我们除了接受一手的 ChatGPT 信息,还可能到处看到二手的 ChatGPT 的半加工文章、播客和视频。大量的 ChatGPT 产出的信息将我们淹没,下一代的小朋友会如何成长起来?他们会变成像 ChatGPT 一样思考、一样讲话吗?

小结

只希望 ChatGPT 能够成为一个好工具,但不要成为人们放弃探索好奇心和思想边界的借口。

附

最近,和学中医的朋友也聊到 ChatGPT。友人深深表示部分传统中医脉络可能因为没有数字信息沉淀,而在这次智能化转型中从网络世界销声匿迹。

如有任何这类担忧的朋友,都可以我号留言,探讨可行的合作和帮助。