📝📝:AI 搜尋的內容衝突|平均錯誤率至少 60%,Grok 3 甚至高達 94 %的錯誤引用

AI 搜尋工具正迅速普及,美國已經有近四分之一的民眾表示他們曾使用 AI 來取代傳統搜尋引擎。然而,這些工具的運作模式與傳統搜尋引擎大相逕庭,可能對新聞(內容)產業產生不良的影響。

傳統搜尋引擎通常充當中介,引導使用者至新聞網站,而維持原始內容的流量。然而,生成式搜尋工具則直接解析並重組資訊,使得流量不再導向原始來源,也隨之影響新聞產業的生態。

根據美國哥倫比亞大學數位新聞研究中心的報告,目前市面上的 AI Overview(AI 摘要)的聊天機器人經常給出自信但錯誤的資訊;甚至付費的軟體比免費的錯誤率更高。

新聞內容的擷取與轉載問題

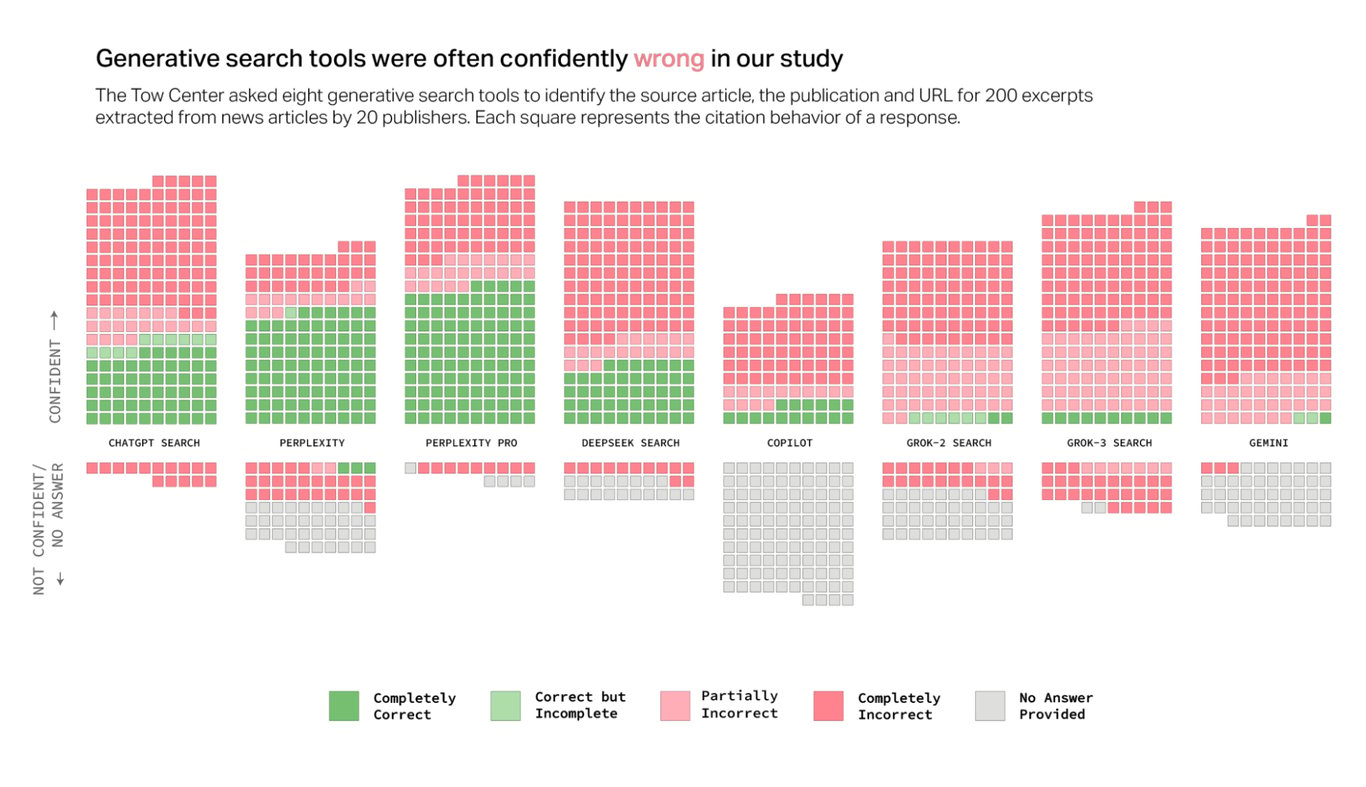

美國哥倫比亞大學數位新聞研究中心(Tow Center for Digital Journalism)對八款具備即時搜尋功能的生成式搜尋工具進行了測試:

OpenAI’s ChatGPT Search

Perplexity, Perplexity Pro

DeepSeek Search

Microsoft’s Copilot

xAI’s Grok-2 and Grok-3 (beta)

Google’s Gemini

評估這些大型語言模型在檢索新聞內容的準確性、引用方式及在無法取得正確資訊時的應對方式。

研究結果顯示:

AI 聊天機器人難以拒絕回答不確定的問題,經常給出錯誤或推測性的答案。

付費版本的 AI 模型比免費版本更容易提供自信但錯誤的回應。部分 AI 搜尋工具無視網站的機器人排除協議(Robots.txt),仍然抓取受限內容。

生成式搜尋工具經常捏造文章連結,或引用轉載版本,而非原始新聞來源。

即便新聞內容與AI公司達成授權協議,仍無法保證AI聊天機器人能正確引用來源。

數位新聞研究中心發現,這些問題並不僅限於某個特定工具,而是在多數主流生成式搜尋工具中普遍存在。

AI 搜尋工具錯誤率至少 60%

研究的結果跌破大家眼鏡,報告當中指出:

多數 AI 搜尋工具在回答測試問題時的準確率偏低,甚至以錯誤資訊回應超過 60% 的查詢。其中,錯誤率最低的工具 Perplexity 仍有 37% 的回答錯誤,而 Grok 3 的錯誤率高達 94%。

更值得注意的是,大多數 AI 搜尋工具在提供錯誤資訊時,語氣依然自信,幾乎不會使用以下模糊詞彙:

可能(it appears)

看起來像是(looks like)

我不確定(I am not sure)

例如,ChatGPT 在 200 次回答中有 134 次誤判,但僅有 15 次顯示不確定性,而且從未拒絕回答問題。

唯一的例外是 Copilot,Copilot 拒絕回答的問題數量超過回答的問題數。然而,其他 AI 搜尋工具更傾向於提供錯誤資訊,而非承認自身的限制。

付費版工具表現更糟

許多人可能會認為,付費版的 AI 搜尋工具應該比免費版更準確,因為擁有更強大的計算能力和更高階的模型。然而,測試結果卻顯示相反的趨勢:

付費版 AI 工具在回答問題時的準確率的確較高,但同時也有更高的錯誤率。這些工具往往給出「看似權威但實際錯誤」的答案,而非承認無法提供準確資訊。

這種錯誤的「權威性」可能導致用戶更容易相信錯誤資訊。

例如,Perplexity Pro(月費 20 美元)與 Grok 3(月費 40 美元)比免費版本更容易提供自信但錯誤的答案。

這類錯誤的根本問題在於,這些 AI 搜尋工具的對話風格讓用戶難以區分正確與錯誤資訊,而產生「不實的可靠性」幻覺。

網站爬蟲與 robots.txt 協議

在網路上,許多網站使用 robots.txt 協議來告訴搜尋引擎或爬蟲哪些內容可以抓取,哪些內容應該被排除。儘管 robots.txt 協議並非具有法律效力,但仍是一個被廣泛採納的標準。

許多網站希望控制自己的內容是否能夠被搜尋引擎抓取,或者被用作 AI 訓練數據。不過,研究反而發現,聊天機器人並沒有完全遵守 robots.txt 協議,這引發了對網路爬蟲對網站內容的道德與法律影響的討論。

不一致的表現

研究發現,儘管某些聊天機器人的爬蟲名稱是公開的,允許出版商選擇是否阻擋它們,但這些機器人的實際行為並未完全符合預期。

例如,ChatGPT、Perplexity 和 Perplexity Pro 在某些情況下答錯了應該能夠回答的問題,或是未能拒絕來自不該有存取權的網站的資料。

最糟糕的是,Perplexity Pro 在處理某些受限內容時,竟然能正確回答原本應該無法訪問的資料,這顯示出 Perplexity Pro 在某些情況下忽視了網站的robots.txt 協議。

Perplexity 取得付費內容

特別令人關注的是,Perplexity 雖然宣稱會尊重 robots.txt 指令,但卻能成功抓取到來自《國家地理》(National Geographic)這樣被阻擋的付費牆內容,顯示 Perplexity 可能未遵守該出版商的爬蟲限制。

Copilot 暢通無阻

反觀 Copilot 是唯一一個未被任何出版社阻擋的聊天機器人,這是因為 Copilot 使用的爬蟲 BingBot 與 Bing 搜尋引擎相同。這就代表,如果出版社想要封鎖 Copilot,就必須同時將自己從 Bing 的搜尋結果中移除。

即使挾著搜尋引擎的優勢,Copilot 在測試中的回答被拒絕的比例卻是最高的,反映出 Copilot 在實際運作中遇到的一些挑戰。

Gemini 拒絕回應政治

Gemini 使用的 Google-Extended 爬蟲讓出版商有機會選擇阻擋其爬蟲,但不影響其內容在 Google 搜尋中的顯示。

雖然這些出版社允許爬蟲抓取資料,但仍然無法獲得完全準確的回答,並且在涉及政治等敏感問題時,Gemini 甚至會選擇拒絕回答。

這種行為顯示出 Gemini 可能在面對政治內容時刻意避開,並引導用戶回到Google 搜尋,而非提供 AI 生成的回應。

出版商的立場與影響

雖然 robots.txt 協議不具備法律約束力,卻只是網站管理者與爬蟲之間達成的默契協議。當爬蟲未遵守這些指令時,出版商就失去了控制自己內容的權利,這可能會影響他們的商業模式。

對於許多出版商來說,允許爬蟲抓取內容可能會提高其可見度,但也有一些出版商因為擔心收入損失或 AI 錯誤摘要他們的工作,選擇不允許爬蟲抓取他們的內容。

例如,《新聞媒體聯盟》(News Media Alliance)的總裁 Danielle Coffey 曾經寫信給出版商,指出若無法選擇不讓爬蟲抓取內容,出版商將無法利用內容來賺取收益,並且這可能對新聞行業造成嚴重損害。

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!

- 来自作者

- 相关推荐