transformer encoder

IPFS

transformer跟self attention有密切的關係。

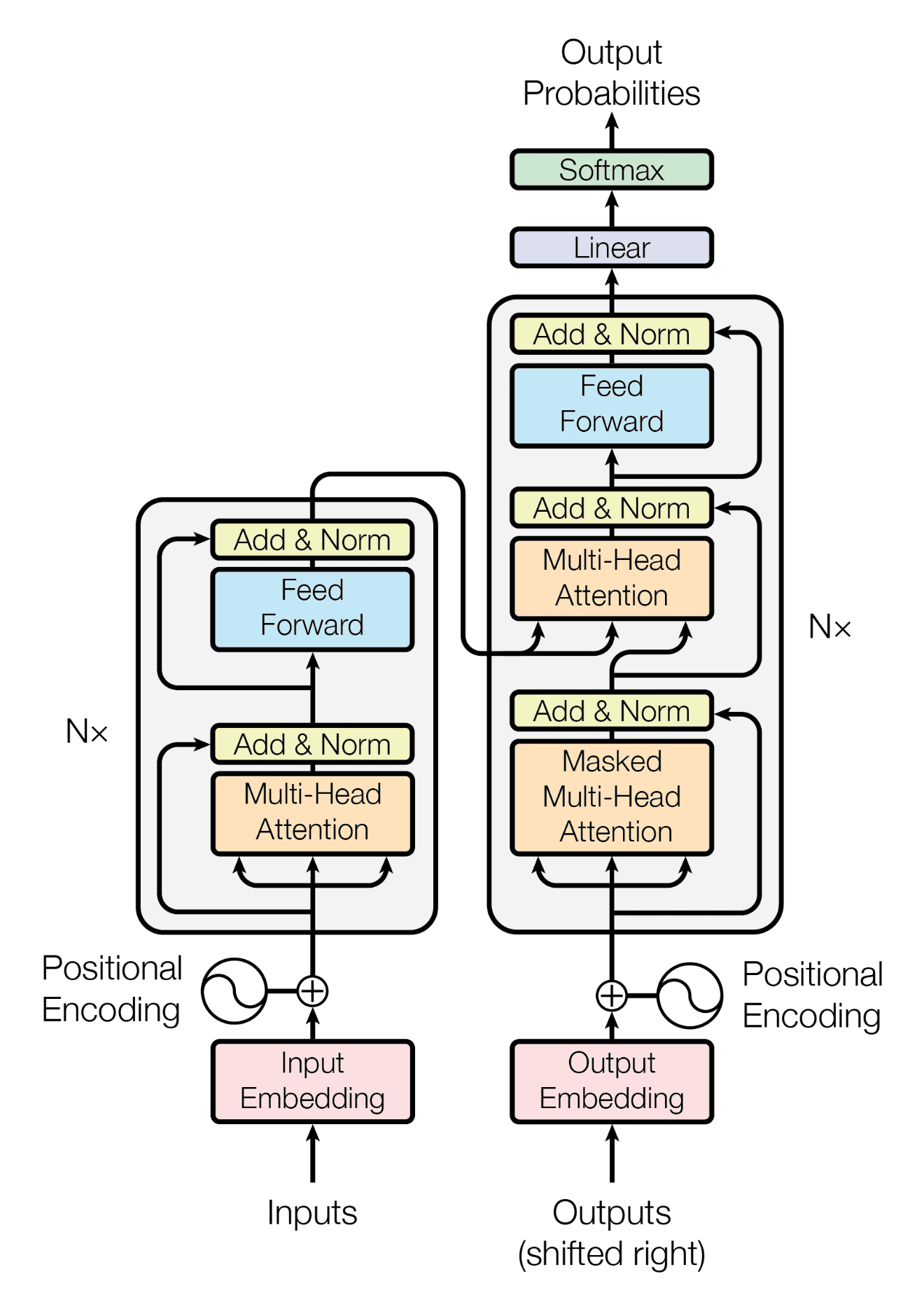

那transformer到底在做甚麼呢,它可以用來做NLP(自然語言處理)例如翻譯、找重點或語音轉換之類的,因為transformer的本質seq2seq所以也可以用來做圖像辯識之類的。

看transformer的model可以看到裡面有多層的self attention可以說有一半都是他。

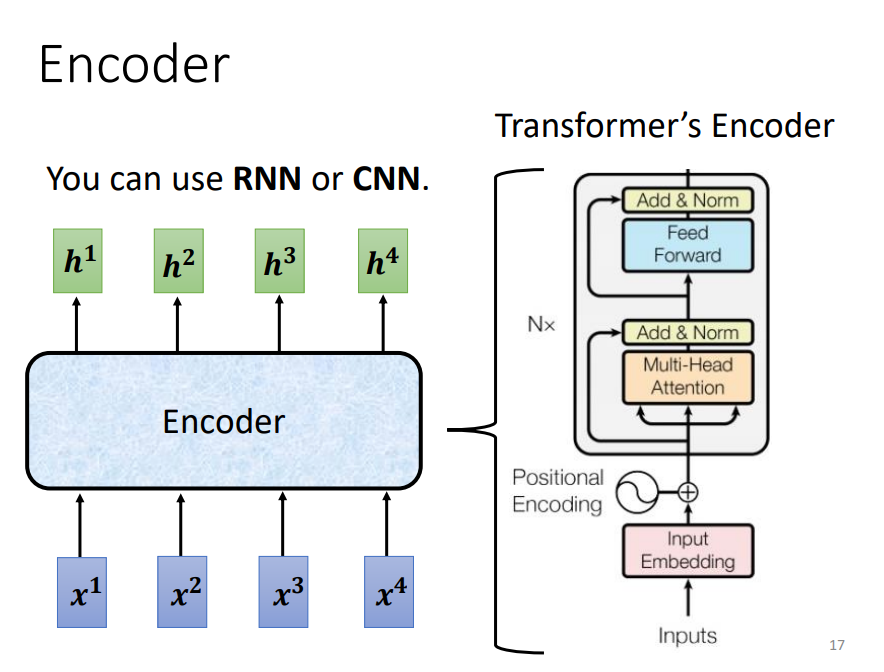

transformer中的架構主要分為encoder和decoder,encoder是將你輸入的向量的重點提取出來,decoder則是去解釋你提取出來的特徵將它輸出為我們想要的輸出。

那transformer的encoder在做什麼呢?

他要做的事就是給一個向量,輸出一個向量。首先輸入前要使用positional encoding用來加上位置訊息。

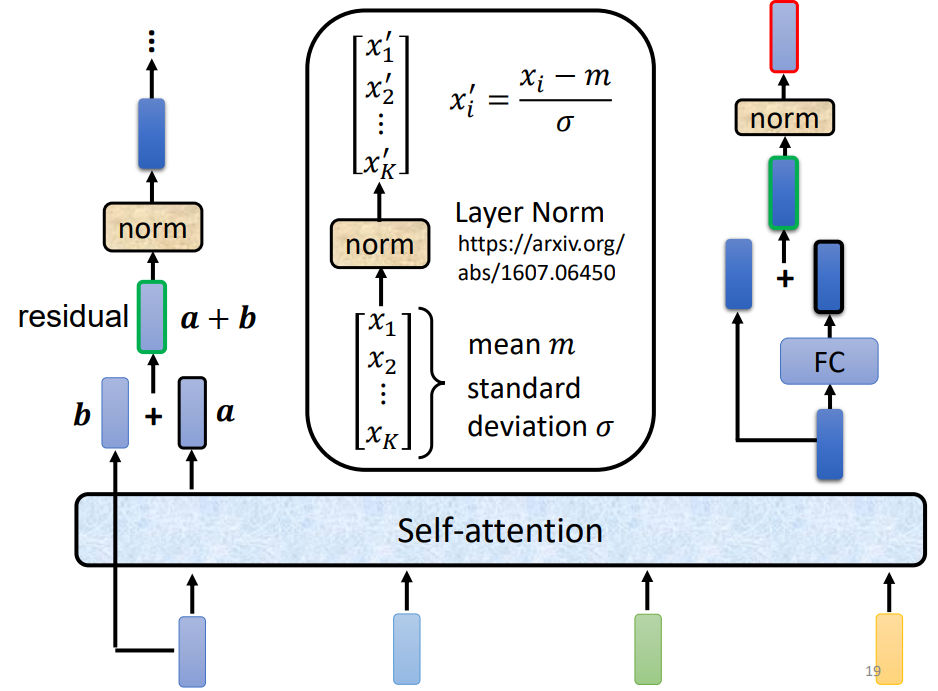

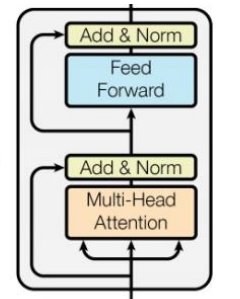

這裡用到的self attention跟一班的self attention不太一樣因為它會將輸入加上結果才會得到輸出,這種方式稱為]residual self attention。

但這不是這一個區塊的最後輸出,做完resudual self attention後還要做normalization然後再接上使用了residual的fully connected layer最後再用一個normalization得到這個black的最終輸出,然後這個操作會進行很多層。

經過層層處理過後,我們得到了一個向量,接下來就是decoder的回合了。

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!