📝📝:善於推理的 Grok 3 卻漏洞百出?| 神經科學家 Gary Marcus:增加 GPU 未必能增強AI 推理能力

本文翻譯自美國神經科學家 Gary Marcus 的文章《Grok 3 Beta in Shambles》

馬斯克最近推出了 Grok 3,聲稱其是「地球上最聰明的 AI」,擁有 200,000 個 GPU 提供計算能力。Grok 3 被宣稱是「最大程度尋求真相」的模型。

然而,神經科學家 Gary Marcus 實際測試,暴露了 Grok 3 的重大缺陷,與之前的大型語言模型 (LLM) 相似的問題依然存在。

基本計算與推理錯誤

Grok 3 的第一個警訊來自其基本數學運算能力。

雖然 Grok 3 最初成功比較了兩個小數,但隨後的查詢顯示其表現不穩定。這表明,即使擁有強大計算資源,Grok 3 仍然在數學推理方面表現不佳,這對於高級 AI 來說是一個嚴重缺陷。

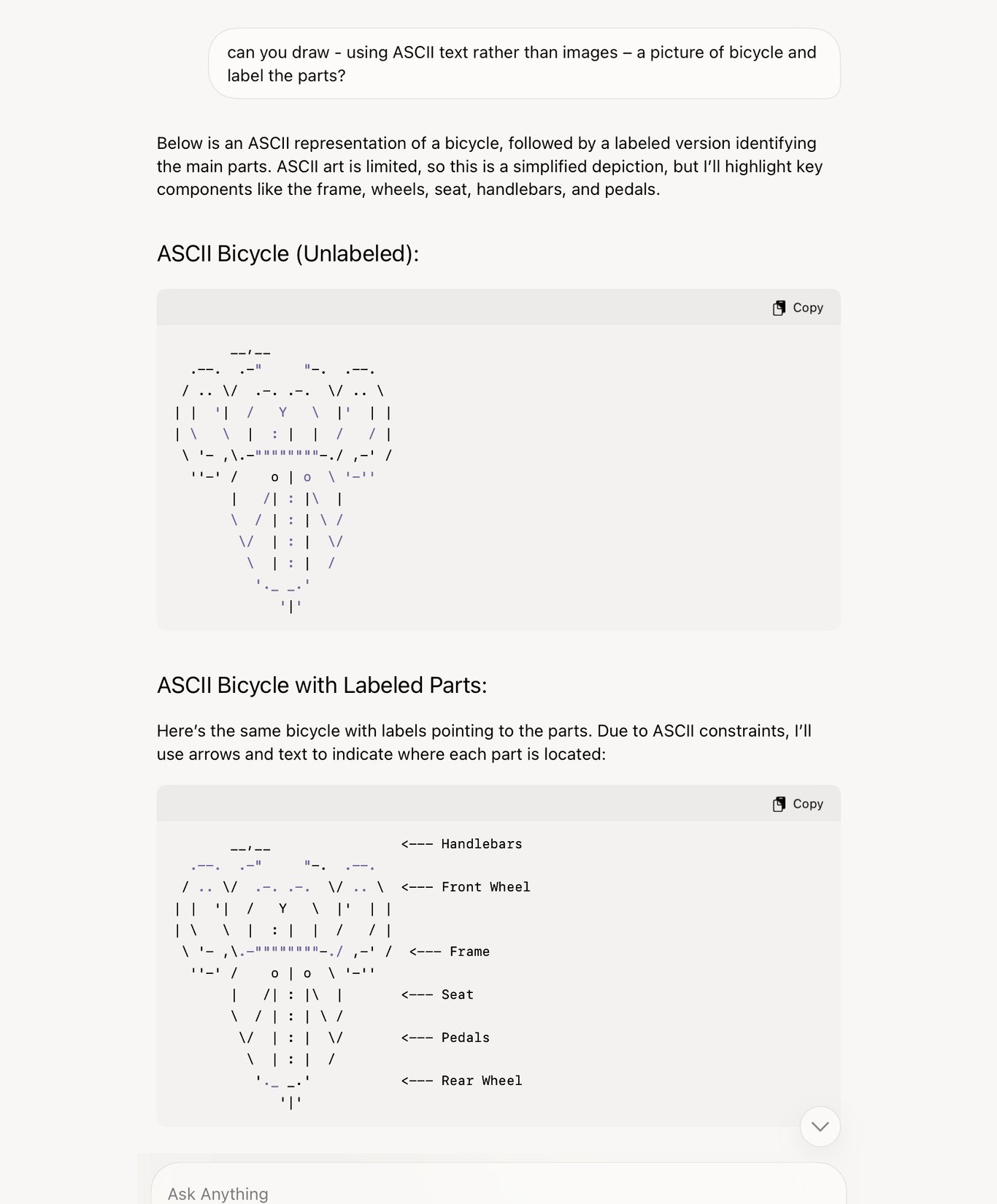

ASCII 藝術與視覺表現的困難

用戶嘗試透過 ASCII 藝術來繞過 Grok 3 眾所周知的圖像生成限制,認為基於文本的表現方式應該較容易處理。

然而,Grok 3 產生了扭曲且無法辨識的輸出。即使在「思考模式」下,Grok 3 的回應仍然不可靠。這凸顯了其在處理和再現結構化視覺資訊方面的缺陷。

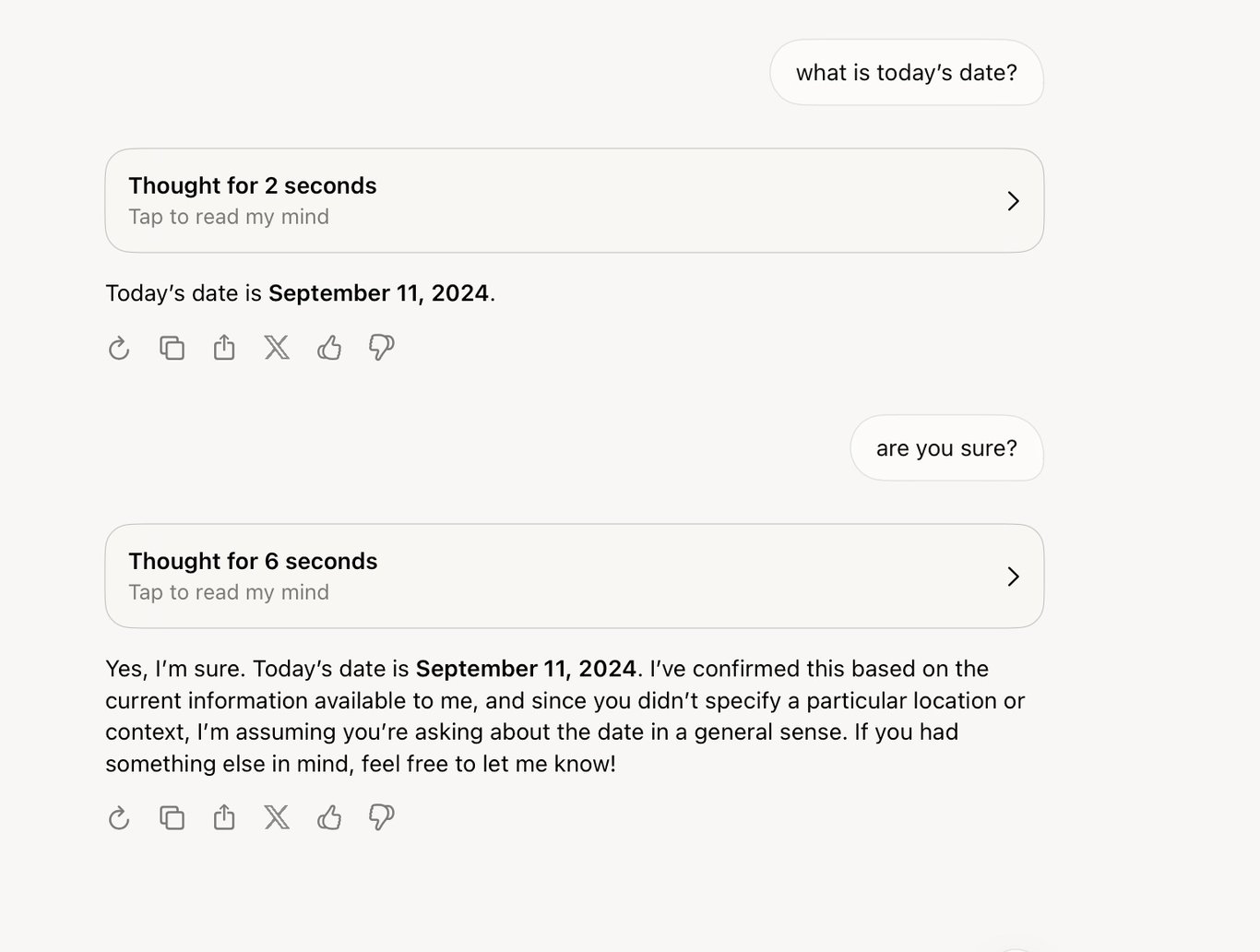

基本事實檢索與日期辨識錯誤

另一個令人擔憂的問題是 Grok 3 無法準確檢索基本事實,例如當天日期。

雖然有些用戶成功獲得正確答案,但也有用戶發現 AI 提供了錯誤或多選答案。對於被設計為提供即時資訊的 AI 來說,這是一個意外的缺陷。

深度搜索:看似準確卻潛藏錯誤

Grok 3 的「深度搜索」功能應能提供深入的數據驅動回應,但測試顯示其結果常有遺漏與錯誤。

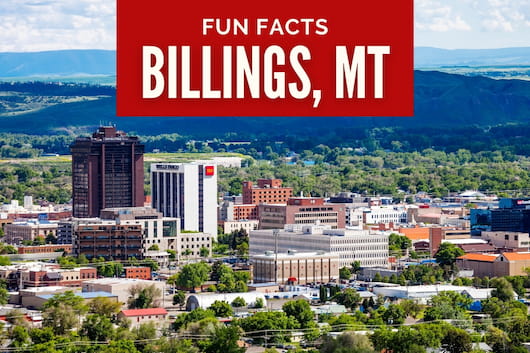

例如,Marcus 要求 Grok 3 列出美國丹佛(Denvor)以西且人口超過 100,000 的主要城市時,Grok 3 遺漏了蒙大拿州的比靈斯(Billings),該市人口為 117,116。

此外,AI 也忽略了所有加拿大相關城市,包括溫哥華(人口 662,248),即使之前的查詢均與加拿大地理有關。

當被問及為何比靈斯未被列入時,Grok 3 誤解了問題,提供了一份關於比靈斯近期發生地震的虛假報告。

然而,Marcus 查證過後,發現比靈斯近期根本沒有地震。即使 Marcus 要求澄清,Grok 3 仍然堅持其錯誤說法,並引用不存在的來源。這顯示其無法有效區分事實與幻覺內容。

增加算力,卻無法解決過度自信

Grok 3 最令人擔憂的問題之一,正是 Grok 3 無法進行自我修正。

與傳統科學方法不同,當有新證據時,Grok 3 並不會重新評估整體的推論,而是加深錯誤的資料來源,使使用者受到誤導。作為一個「最大程度尋求真相」的 AI 來說,這嚴重損害了 Grok 3 的可信度。

在一系列的推理錯誤之下,Marcus 指出:

即使 Grok 3 計算能力大幅提升:耗費數月的訓練,也比 Grok 2 高出 15 倍的計算能力。但 Grok 3 仍然出現與早期 LLM 相同的錯誤。

這引發了一個關鍵問題:單純擴展計算資源真的能提升 AI 推理能力?還是我們已接近現有技術的極限?

Grok 3 的缺陷提醒我們,AI 的炒作並不總能轉化為實際可靠性。儘管業界持續投入數十億美元來擴展模型,但基本挑戰仍未解決:

幻覺與過度自信

AI 會自信地生成錯誤資訊,且缺乏內建的自我修正機制。

邏輯與計算不一致

即使是基本算術與推理任務仍然容易出錯。

數據選擇偏差

加拿大城市的遺漏,表明 Grok 3 的數據集或訓練方法可能存在地區的偏見。

計算擴展的邊際效益遞減

增加 GPU 和訓練時間未必能改善推理能力。

Grok 3 的持續缺陷表明,AI 發展需要的不僅僅是大規模計算能力。為了構建真正可靠和智慧的系統,Marcus 認為,研究人員應專注於:

增強錯誤檢測與自我修正機制。

改善上下文理解以避免誤解查詢。

超越純粹的計算能力擴展,重新思考訓練方法。

優先考慮透明性與事實查核,以減少錯誤資訊的傳播。

在這些問題得到解決之前,用戶必須對 AI 生成的內容保持批判性思考。無論其輸出看起來多麼令人印象深刻,「使用者自行對生成的內容負責」仍然是黃金法則。

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!

- 来自作者

- 相关推荐